発表への質問の難しさ

はじめに

「ご清聴ありがとうございました。質問がある方?・・・いないようですし時間も迫っているのでここで終わりにしたいと思います。」

自分の発表に質問がほとんど飛んでこない経験をした人は、少なくないのではないでしょうか。このような場面に遭遇すると、「自分の発表が悪かったのではないか」と自己嫌悪に陥ることもあります。そうして、今後の発表の仕方やスライドの構成などを見直す方向に向かうことが一般的です。

しかし、これは発表者だけが抱える問題でしょうか?自分が聞く側になった時、どれだけの人が自発的に質問できるでしょうか?また、質問をすることのハードルはどこから来るのでしょうか?

発表については、発表資料の改善や情報・フィードバックを得る機会が多いですが、「良い質問の仕方」という点に関しては、なかなか具体的なアドバイスは得られません。

そこで、自分が質問したいのにできない時、どこでひっかかるのかを整理するために、自分なりに分類してみました。

注:本記事は、自分のもやもやポイントを記録することが目的であり、質問しやすくなるためのヒントを提供が主目的ではありません。

前提

- 技術的な内容の発表であり、聴衆も技術者

- 聴衆は数人以上を想定し、互いに必ずしも知り合いではない

- 発表は一方的に進み、発表後に質疑応答の時間が設けられる

- 例:学会の口頭発表、会社での論文紹介

質問のしにくさの観点

以下3つの観点*1で整理してみました。

各観点何個か列挙しており、それに対する自分がしている対策が思いつくものは併記しています。

1. 技術的な側面

- 話されている内容に関して、詳しくないため質問が思いつかない。

- 策:理解できなかったことを書き出しておく。

- 理解できなかったことをもう一度詳しく説明してもらうのも質問の一種だと思います。

- 策:理解できなかったことを書き出しておく。

- 聞きたいことがあるがどう質問していいかはわからない。

- 策:質問のテンプレートを用意しておくことで、疑問点を質問の形に整形しやすくなる。

- 例:

- 今後の展望について:他にどういった応用が可能なのでしょうか?

- 用語について:◯◯とは△△ということでしょうか?

- 手法について:◯◯と△△の違いはどこにあるのでしょうか?

- 例:

- 策:質問のテンプレートを用意しておくことで、疑問点を質問の形に整形しやすくなる。

2. 心理的な側面

-

質問すること自体が恥ずかしい。

-

質問内容があやふやで変なことを聞いていないか不安になってしまう。

- 策:短い質問に分解する。

- 質問があやふやなときは自分の中で一度整理し直すと聞きたいことが見えてくることがあります。

- 策:短い質問に分解する。

- 途中から参加したため、すでに言及されているかもと思ってしまう。

- 策:資料が共有されているのであれば疑問点が言及されていたかをさらっと探してみる。

3. 記憶的な側面

- 気になることがあったはずだが思い出せず、質問ができない。

- 策:聞くときに少しでいいのでメモを残す癖をつける。

- ページ数などをメモっておくと、ページ数を伝えて意思疎通が便利になるのでおすすめです。*4

- 策:聞くときに少しでいいのでメモを残す癖をつける。

最後に

上記では触れませんでしたが、他の人の質問を聞くだけでもどういった質問が鋭いか・上手いかなどはわかるときもあると思うので色々と発表を聞くのが個人的には良いと思っています。また、他の人の質問を聞いて追加の説明を聞くと新たに質問が思い浮かぶこともあるので追って質問するのでも良いとは思います。

将来的には、スライドからLLMなどを用いて質問を生成し聴衆が聞きたい質問に投票するといったスタイルの発表が生まれる可能性もあるなとも思いますが、またそれは別の話ですね。

2022年読んでよかった本

今年もそこそこ本を読んだ気がするので備忘録がてら。

現代思想入門 千葉雅也

人工知能に哲学は必要だろうと思っていたので、いいきっかけになるかなと思って読んでみた。

著者の千葉さんは昔以下の記事を読んで知っていたが、なかなかどうしておもしろ本であった。 自分が常日頃考えていることの一部が言語化されていて先人の知恵を感じた。

https://corp.netprotections.com/thinkabout/2404/

創るためのAI 徳井直生

創造というものに興味があったことかつ人工知能を少しだけかじっている人間として読んでおいて損はないかなと思って読んでみた。

著者が携わった創作×AIのそれこそ哲学的なお話もあって興味深かった。画像生成AIがすごく流行る前に読んでいたのもあってその盛り上がりを今までと別視点で見れた気がする。(画像生成AIで話題になるのはどちらかというと倫理面な気もするが)

コンセプトのつくりかた 玉樹真一郎

まだない価値をどうすればいいんだろうと考えあぐねてtwitterで見かけたこちらの本を読んでみた。

Wiiの企画に携わった方の話でその大まかな経緯や流れを追体験できるかのような読後感に浸れた。一方でここまでトントン拍子にいかせるのは難しいなぁとも感じた。

アオのハコ

週間少年ジャンプで連載されてる漫画。いちご100%を読んでるときのような懐かしさを味わえる。

今年はあまり本が読めなかった。Kindleが壊れたことにより風呂場での読書週間が消えてしまったためである。買い直さないと……

最近の世界が少しハーモニー(伊藤計劃)に近づいているような感覚を覚えるので読み直したい。

2021年読んで良かった本

今年もそこそこ本を読んだ気がするので備忘録がてら。

日本語の大疑問 眠れなくなるほど面白い ことばの世界

今年はゆる言語学ラジオ(https://www.youtube.com/channel/UCmpkIzF3xFzhPez7gXOyhVg)というラジオにハマったのですがそのTwitterで知りました。 NINJALこと国語研の方達のコラム形式になっていて一つ当たりが短くまとまっていて隙間時間でも読めて良いです。

日本語の奥深さを日々痛感しています

こちらも上記のゆる言語学ラジオで知りました。朝日新聞の校閲の方たちのコラムになっていて記事観点で日本語の多様性を知ることができて面白いです。言語は変わりゆくものだし曖昧なものなのだなと改めて思いました。

最後の秘境 東京藝大―天才たちのカオスな日常―

昨年挙げたブルーピリオドを読んでいたら東京藝大に興味が湧いたので上記を読んでみました。奥様が美大生の著者の芸大生に対するインタビュー形式でまとまっていて、美術・音楽両方の学部の様々な方のお話が載っていて面白いです。(King Gnuの井口さんも出ていました。)

自閉症は津軽弁を話さない 自閉スペクトラム症のことばの謎を読み解く

ネットで話題になっていたので読んでみました。研究・調査に至る過程が興味深いですし、普段馴染みのない分野の話なので色々知ることができて良い本でした。(小並感)

知ってるつもり 無知の科学

店頭で見かけて購入しました。表紙で煽ってくるので流石に自転車のチェーンくらいわかるという思いで読み始めましたが、なかなか面白い本でした。 説明深度の話とかは確かにそうだなと思いました。

BLUE GIANT

ジャズサックス奏者を目指す青年の話。漫画なので音は聞こえてこないのですが、絵柄故に音が聞こえてこなくてもなにか引き込まれます。アニメ映画化もされるそうなのでそのときは音響がいい映画館で見てみたいものです。

https://www.amazon.co.jp/dp/B00GSMDY48www.amazon.co.jp

女のいない男たち

ドライブ・マイ・カーという映画を見てすごく良かったので原作にあたる村上春樹の本を購入してみました。村上春樹の文を読むのは実は教科書以外では初だったので良く見かける”村上春樹っぽい”文というのはこういう文なのかとなりました。この本がいいというよりはこの本を含めた体験(この原作からあの映画になるのかぁ〜といった感情)が良かったです。合わせて試聴してみると良いものです。

逆に頓挫した本は「両利きの経営」などです。経営とかの話はよくわからない。

2020年読んで良かった本

2020年はそこそこ本を読んだつもりなので備忘録的に記録をば。

新 企業の研究者をめざす皆さんへ

色々な企業・組織を渡り歩いてきた著者による様々な視点からの企業研究者の姿が描かれていて参考になる。数ヶ月に一回読み返している。実践はできていない。

自走プログラマー ~Pythonの先輩が教えるプロジェクト開発のベストプラクティス120

Python開発で今まで気にしていなかったところとかが知れてよかった。後半はDjangoの話で馴染みがなかったが前半だけでも価値があった。

会計クイズを解くだけで財務3表がわかる 世界一楽しい決算書の読み方

お金周りの知識が無いなと思って購入。財務3表に関してクイズ形式で興味を持ちながら読み進めることができた。著者はtwitterでもクイズを出しており時々覗くと面白い。

リモートワークの達人

Twitterで見かけて購入。仕事におけるハック的な本は色々読んできたが(実践はできていない)この本は結構コンパクトにまとまっていてよかった。

ブルーピリオド

美大受験を目指す高校生の話。数年前に美大の学祭を覗いたこととかも思い出してエモかった。作品としては非常に丁寧に描かれていて良い。

放課後さいころ倶楽部

女子高生がボードゲームをする話。ライトなゲーム(ニムトなど)からヘビーなゲーム(ツォルキンなど)まで手広くゲームを扱いつつキャラクターの成長も描かれていて良い。

トピックモデルを俯瞰して学ぶ

本記事は,自然言語処理 Advent Calendar 2019 - Qiita です.

はじめに

本記事ではトピックモデルと呼ばれるモデル・分野の中で最も有名なLatent Dirchlet Allocation, 通称LDA*1 とその周りのトピックモデルに関して,どんな資料があるのか?,どういった研究があるのか? といったことに主眼をおいてトピックモデルの研究とかを昔していた私の独断と偏見によるリストアップを行いました.

私の頭は2017年くらいで止まっているので、間違っている点があったり、今の主流とは異なる可能性もありますが、 暖かくご指摘いただけると助かります.

Latent Dirchlet Allocation[Blei+,03]を始めとするトピックモデルを学ぶに当たって

- 何が参考になるのか

- どういった研究があるのか?

- 実際にどうやって使うのか?(まだ出来てないよ・・・)

といったことに焦点をあててサクッと解説していきたいと思います.

トピックモデルとは

トピックモデルとは生成モデルの一種であり,各文書は複数のトピックから確率的に生成されたものとして捉えるモデルのことで, ニュース記事から「政治」「経済」「スポーツ」などのトピックを抽出することができるモデルとして説明されることがあります. トピックモデルに関する説明はあらゆるところでされているので自分の腑に落ちる捉え方をしていただくのがいいと思います.

以下では,参考となる書籍・Webページを紹介します

参考資料

書籍

機械学習・自然言語処理に関する入門的な書籍であれば,トピックモデルについて数ページ割いて説明がされることがあると思いますが, トピックモデルだけを扱った書籍は以下の2つだけかと思います.

トピックモデル (機械学習プロフェッショナルシリーズ)岩田 具治*2

- LDAに入る前の導入(ユニグラムモデル,混合ユニグラムモデルにも触れています)が丁寧な本でさーっと目を通すことができるため, 軽く勉強したい人にはおすすめです.

トピックモデルによる統計的潜在意味解析 (自然言語処理シリーズ)佐藤 一誠*3

- 東大の佐藤さんによる書籍です。上の本よりも少し難しいですが、自分で手を動かしたりする際にはこちらの書籍の方が参考になりました。

Webページ

H24:Introduction to Statistical Topic Models

統計数理研究所の持橋さんと当時NTTCS研の石黒さんによるトピックモデルに関するチュートリアルスライドです. 非常に網羅的な資料であり,トピックモデルとその拡張,そして言語データ以外への適用についても触れられており, どういった研究が行われてきたのかを把握するのに便利です.

https://shuyo.hatenablog.com/category/LDA

サイボウズの中谷さんによるブログです. 複数回に渡りトピックモデルについて記されており,研究を始めた頃に式の気持ちを把握するのにたいへん助かった記憶があります.

http://www.ccs.neu.edu/home/jwvdm/teaching/cs6220/fall2016/assets/pdf/blei-kdd-tutorial.pdf

Latent Dirchlet Allocationの著者であるDavid Blei氏によるチュートリアル資料です. こちらもトピックモデルについて網羅的な記載があります.

上記の本の著者でもある東大の佐藤さんの私のブックーマーク(人工知能学会)でのトピックモデルについての特集です. いろいろな論文や注目学会が列挙されています.

トピックモデルの研究

トピックモデルの研究は大きく分けて3つに分けられます.

- モデルの学習方法と省メモリ化・高速化

- 対象のモデル化

- 結果の見せ方

モデルの学習方法と省メモリ化・高速化

学習の仕方の理論的解析から,学習をいかに時間計算量的, 空間計算量的に効率よく学習するのかという改良まで,幅広い研究が存在していて,トピックモデルの学習に関しては大きく2つに分けられます.

- 変分ベイズ法

- ギブスサンプリング

変分ベイズ法に関連した研究

変分ベイズ法はベイズ学習において事後分布が解析的に求められない時などに用いられる手法で,LDA の原著でも用いられているものです.

事後分布を計算が容易な分布(近似事後分布)で仮定しますが,因子分解が可能であるという仮定を置くことが多いです. 近似事後分布の推定を行うために,近似事後分布と本来の事後分布とのKL 情報量を最小化を試みる際に,イェンセンの不等式を用い,対数周辺尤度に関する 変分下限に落とし込むことで解ける形にします.

また変分ベイズ法における一部の変数を積分消去することでより簡略的な推論が行えるcollapsed Variational Bayse(CVB)を 用いたものなども提案されています.

ギブスサンプリングに関連した研究

ギブスサンプリングそのものを使うことは少なく,collapsedGibbs Sampling(CGS)を用いることが多いです.

CGSでは, 目的の事後分布からのサンプル生成の代わりに、より計算コストの低い条件付き確率分布を構成することで確率変数らを交互にサンプル生成することで、 目的の事後分布からのサンプルを生成を可能にするギブスサンプリングにおいて、ある確率変数を経てサンプリングされていた確率変数に関して、 周辺化を行うことでより簡便なサンプリングを行う手法です.

LDA に関しても変分ベイズ法の後にその有用性が示されており,これは後続のモデルらでも実装の容易さゆえによく採用されています。

一般的にCGSは変分ベイス法に比べ性能が良いことが知られていますが, 各文書の各単語についてそれぞれサンプリングを行わなければならず,CGSはその計算量がボトルネックとなってしまいます.

このボトルネックの要素として基本的に各単語のサンプリングとは各単語に割り当てられるトピックのサンプリングであり, これは多項分布からのサンプリングになり一般的にトピック数に比例して計算量が増えてしまいます.

この部分に対する効率化として

- FastLDA

- sparseLDA

- AliasLDA

が挙げられます。

上記の他にも大規模データのバッチ学習時の並列化やオンライン学習などの改良も提案されています.

対象のモデル化

対象の性質をどうモデル化をするかという点に着目して,モデルの潜在変数を増やしたり,分布を変更したりすることによってこれを実現しています.

この拡張のしやすさがトピックモデルがあらゆる研究に波及していった理由の一つでもあります.

いくつかのモデルに関して箇条書き形式で記してみます,興味があるものがあれば論文を読んでみてください. (論文の引用元urlに一貫性がないのはご容赦ください.)

Biterm Topic Model(BTM)

- [論文] http://www.bigdatalab.ac.cn/~lanyanyan/papers/2013/WWW2013-yan.pdf

- LDAは短文のデータセット(マイクロブログ)に弱いのでそれをトピックからbitermが生成されるという仮定にしたもの

Twitter-LDA

- [論文] https://ink.library.smu.edu.sg/cgi/viewcontent.cgi?article=2374&context=sis_research

- BTMと同様に短文への対処でTwitterに焦点を当てたもので、一人のユーザの複数のツイートを1文として捉えるようにしたもの

Author Topic Model(ATM) *[論文] https://arxiv.org/abs/1207.4169

- [実装] gensim: models.atmodel – Author-topic models

- 各文書の著者情報も入れ込むモデルを提案しており、各トピックに対してどの著者がどれくらいの割合で属するかといったことを知ることが可能

Polylingual Topic Model(PLTM)

- [論文] https://www.aclweb.org/anthology/D09-1092/

- 日本語と英語の文書対などのようなパラレルな文書データに対してのモデル化

Corresponding Topic Model(CORR-LDA)

- [論文] http://www.cs.columbia.edu/~blei/papers/BleiJordan2003.pdf

- 文章についたタグ情報などの補助情報も同時にモデル化

Relational Topic Model(RTM)

- [論文] http://proceedings.mlr.press/v5/chang09a/chang09a.pdf

- ネットワーク構造を持つ文書群に対し,各ノードの内容に立ち入ったモデリングを行った(論文を対象として,各ノードが文書,各ノードの内容が文書の内容,引用関係がリンクに対応)

Correlated Topic Model (CTM)

- [論文] https://arxiv.org/pdf/0708.3601.pdf

- トピック間の相関を共分散行列で表現するためにトピック分布の事前分布に正規分布を導入したモデル. 正規分布は多項分布の共役事前分布ではないため推論が難しい.

Hierarchical TopicModel(HTM)

- [論文] https://papers.nips.cc/paper/2466-hierarchical-topic-models-and-the-nested-chinese-restaurant-process.pdf

- Nested Chinese Restaurant Process を基にした生成過程を考え、トピック集合は木構造を持っているとしてモデル化

Pachinko Allocation Model (PAM)

- [論文] https://people.cs.umass.edu/~mccallum/papers/pam-icml06.pdf

- トピックに階層構造を導入し従来のトピックの上に上位のトピックを仮定することで、トピック間の関係を捉えたモデル

Multi-Grain LDA(MG-LDA)

- [論文] https://arxiv.org/pdf/0801.1063

- Global Topic・Local Topicを導入. 今まで文章全体を捉えていたものを一文単位からも考慮し,同一話題内でのトピックの粒度を変えたトピックの抽出が可能

Dynamic Topic Model (DTM)

- [論文] https://mimno.infosci.cornell.edu/info6150/readings/dynamic_topic_models.pdf

- 直前の時刻からの時間発展のダイナミクスを正規分布を導入し,ランダムウォークさせ,カルマンフィルターを用いるためV 次元の潜在変数ϕ の状態空間遷移を捉えるという複雑な形になっている上に共役事前分布ではないので厳密な推論は困難.

Multiscale Dynamic Topic Model (MDTM)

- [論文] http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.176.39&rep=rep1&type=pdf

- MDTM は,複数の時間スケールでのトピックの発展を考慮したモデルである.例えば,政治に関して,国会や総理大臣などの長期間にわたり頻出する単語もあれば,特定の法案名や事案のように数日か数ヶ月しか出現しない単語もあり,このような多重スケール性を考慮した

結果の見せ方

トピックモデルの説明をする際に、「スポーツ」「経済」「政治」などのトピックが〜と言った説明をされることが多いため、 トピックモデルを使うと勝手にトピックごとにラベルをつけてくれるものと思い込んでしまいますが、実際はそうではありません. *4

そこで結果を解釈しやすくするため,画像を用いるもの*5,ワードクラウドなどトピックの魅せ方の比較*6などの研究が行われていたりします.

また上記に加えて評価に関しても焦点があたることがあります.

定量的な評価としては, * Perplexity * Coherence に基づく評価が行われます. これらに関しては,以下のslideshareの資料を読むとなんとなくはつかめると思います. 上記で上げた本などでも触れられているので参考にしてみてください.

www.slideshare.net https://www.slideshare.net/hoxo_m/coherence-57598192

上記ではまったく触れませんでしたがニューラルネットを用いたトピックモデルも複数*7提案されています, 他のモジュールとくっつけたいなどの欲求がある方はそちらを掘ってみることをおすすめします.

実験(あとで追記します)

ACL anthologyから取ってきた論文のabstractを対象に実験をしているのですが、結果をまとめていないので後日載せます・・・(年内には・・・)

*1:NLPer外でLDAと呼ぶときはLinear discriminant analysisを指す場合もあるので注意しましょう.

*2:https://www.amazon.co.jp/dp/4061529048

*3:https://www.amazon.co.jp/dp/4339027588

*4:トピックは単語の多項分布として表現されるので

*5:https://www.aclweb.org/anthology/N13-1016.pdf

Why Didn’t You Listen to Me? Comparing User Control of Human-in-the-Loop Topic Models (ACL2019)を読んだ

Why Didn’t You Listen to Me? Comparing User Control of Human-in-the-Loop Topic Models *1 を読んだので軽くまとめようかと。

読もうと思った理由はトピックモデルだったからです、自分の守備領域なのでさらっと読めるかなと。

本論文はACL2019のshort paperで、論文の流れに沿ってまとめます。 (出てくる図は論文からの引用です)

論文

- タイトル: Why Didn’t You Listen to Me? Comparing User Control of Human-in-the-Loop Topic Models

- 著者(所属): Varun Kumar(Amazon Alexa), Alison Smith-Renner(University of Maryland), Leah Findlater (University of Washington), Kevin Seppi(Brigham Young University), Jordan Boyd-Graber(University of Maryland)

- コード: 公開無し

概要

- Human-in-the-Loopなトピックモデル(HLTM)に関して3つのアプローチを試し、比較評価を行った

- 知識の入れ込み方( 制約条件を入れ込む or 事前情報を入れ込む

- 推論方法(Collapsed Gibbs Sampling or Variational Inference)

- ユーザのFeedBackを反映できたかの指標の提案

- 制約条件の追加と事前情報の加味による、トピックの質と操作性の違いに関して検証を行った

そもそもHLTMとは?

トピックモデルと言うと、Latent Dirichlet Allocation(LDA)を指すことが多いと思いますが、 LDAのような通常のトピックモデルを用いると一貫してないトピックを含むことが往々にしてあります。

(トピックの一貫性といった話題に興味がある方はMachine Reading Tea Leaves: Automatically Evaluating Topic Coherence and Topic Model Quality (EACL2014)*2 に一度は目を通すことをお勧めします。)

これを改善するために"人の知識"を入れ込むことを試みられています。 例えば以下のような操作を行うことが挙げられます。

- トピックへの単語の追加

- トピックのマージ

- 文書の除去

一方でユーザのFeedBack(FB)の入れ込み方として

- {つながる|つながらない}といった制約条件

- 事前情報

- 文書のラベル

などの活用が挙げられます。

しかし、上記のような操作や活用を適切に比較・評価できるような枠組みは存在していないので、本論文ではその部分に焦点を当てています。

このあたりの問題意識は "Interactive Topic Modeling (ACL2011)"*3が詳しかったりします。*4

比較アプローチ(3つ)

- モデルが学習したものを一部忘却させ、トピックからワードの割り当てを除く 2.新たな情報(ユーザFB)を挿入する

1の観点に関しては、ギブスサンプリング(Gibbs Sampling)と変分推論(Variational Inference)といった2つのアプローチが考えられる

2の観点に関しては、非対称な事前分布[informed](LDAに置ける・

といったディリクレ分布のハイパーパラメータに相当)*5と制約の追加[constraint](この文書のこの単語はこのトピックに属するといった情報)が考えられる。

上記を踏まえて3つの比較手法を挙げている。

| 比較手法 | 知識の入れ方 | 推論方法 |

|---|---|---|

| info-gibbs | 事前情報 | ギブスサンプリング |

| info-vb | 事前情報 | 変分推論 |

| const-gibbs | 制約条件 | ギブスサンプリング |

ユーザの操作

ユーザがトピックモデルをいじる上で行う操作を既存研究にのっとり7つ挙げられています。

- Remove word トピックtから単語wを除去する操作

- Add word トピックtに単語wを割り当てる

- Remove document トピックtから文書dを除去する

- Merge topics トピックt1とトピックt2とトピックt1にする

- Split topics トピックtとseed words sが与えられた時、sを含むトピック

と含まないトピックtに分割する

- Change word order トピックtにおける単語w2のランクをw1より上にする

- Create topic seed words sが与えられた時に

を作成する

操作性(Control)の評価尺度

トピックモデルの一般的な評価尺度は

- Perplexity

- Coherence

- log-likelihood

などがあげられるけどこれらはモデル自体についての良さの指標であって、 人からのFBを反映できているかといった観点の評価としてみると不十分である。*6

なので新たな評価尺度(Control)を提案するというお話で上記7つの操作に関して各々提案されています。

単語レベルの操作に関しての評価

Remove word・Add word・Change word orderがこれに該当し、

: モデルM1(ユーザのFB前)におけるトピックtのワードwのランク

: モデルM2(ユーザのFB後)におけるトピックtのワードwのランク

とした時に といった実際の変化と、期待される変化の比率で計算される。

文書レベルの操作に関しての評価

Remove documentがこれに該当し、Remove wordとほぼほぼ同様であるが、トピックを文書のランクリストとして捉える

トピックレベルの操作に関しての評価

Create topic・Merge topic・Split topicがこれに該当し、

- Create topic: seed wordsのうちどれだけの単語が新しいトピックに含まれるかの割合

- Merge topic: 結合元のトピックの単語のうちどれだけ、マージされたトピックに含まれるかの割合

- Split topic: 分離前後トピックにおけるcreate topicと同様の計算によって得られる指標の平均

比較実験と結果

コーパス

14のトピックについて各500文書、累計7000文書のニュース記事(ビジネス、法律、・・・)

ユーザシミュレーション

実際の人手を集めるのはコストがかかるので、

- ランダムに操作するユーザ

- 良い操作をするユーザ

をそれぞれシミュレーションで作り上げる*7。

方法

元となるモデルはLDAでトピック数10・20で学習する。 評価に関しては上記のcontrolという指標とCoherenceに関して行う。

結果

- remove wordとmerge topicはどのシステムでも良いcontrolである

- informed priorにおいては add wordとcreate topicも良いcontrolである

- change word orderの項目はどのシステムもcontrolに乏しい

実験結果からinformed priorの方がconstraintよりもcontrolabelであることがわかる。 (constraintはあくまで制約条件であり、十分に共起が起きていなければadd wordしてもトピックに含まれにくいが、 informed priorはそもそも事前分布をいじるので共起以上の関係をおりこめる(意訳))

所感

数年前にInteractive Topic Modelを読んだ時からHuman-in-the-Loopなトピックモデルは人が見るトピックモデルにおいては需要があるなと思っていたので、ちゃんと評価まで提案してくれて良い論文だと思った一方で、具体的な例が載ってないのが少し残念な論文だった。。。 (トピックモデルの論文はトピックをちゃんと例示してほしい・・・)

ちゃんとしたツールとして出てきたらもっと普及するのかなと思ったり、pyLDAvisみたいに視覚的に見れると嬉しいと思ったり・・・

*1:https://arxiv.org/abs/1905.09864

*2:https://www.aclweb.org/anthology/E14-1056

*3:https://www.aclweb.org/anthology/P11-1026

*4:日本語だとここで軽く解説されています。https://qiita.com/kenchin110100/items/4e4ba972fea4690bf9e8

*5:余談ですけど、gensimのLDAでもが更新できることはあまり知られていない・・・?

*6:だけど、上記の評価は行わない論文はトピックモデルにおいてはほぼほぼない気がする...

*7:具体的な方法はappendixに載ってる

Jointly Optimizing Diversity and Relevance in Neural Response Generation (NAACL2019) 読んだ

Jointly Optimizing Diversity and Relevance in Neural Response Generation*1 を読んだので軽くまとめようかと (久々にまとまった文章を書く・・・。)

論文の流れに沿ってまとめます(断りがない限り図は論文からの引用)。

論文

- タイトル: Jointly Optimizing Diversity and Relevance in Neural Response Generation

- 著者: Xiang Gao, Sungjin Lee, Yizhe Zhang, Chris Brockett, Michel Galley, Jianfeng Gao, Bill Dolan

- 所属: Microsoft Research Redmond

- コード: GitHub - golsun/SpaceFusion: A regularized multi-task learning framework by Microsoft Research

(コード公開のところに著者スライドがあった・・・、これを読めば簡単に理解できた・・・)

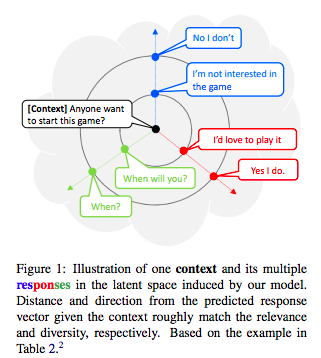

概要

- Neural Conversation Modelにおける問題点は {bland|generic} responseを生成する点

- responseの多様性を考慮したモデルもあるけど、そのためにcontextとの関連性が犠牲になることも・・・

- そこで、 "SPACE FUSION"という提案モデルにより多様性と関連性を同時に捉えられるような潜在空間を導入

- 基となるresponse vectorとの距離と方向により直感的にわかる

- 提案モデルは、自動評価・人手評価どちらでもベースラインに勝る

関連研究

Grounded Conversation Models

- ペルソナ

- 知識

- 対話行為

- 感情ラベル

を利用した対話モデルが提案されている。

=> 提案モデルでは、上記のような補情報を用いず、対話文のみから学習を行う

VAE

VAE/CVAEを用いたテキスト生成も提案されていますが2点ほど問題点が挙げられています。

vanishing latent variable problem

- word dropping とKL annealingによる対処

- bag-of-word lossを用いる対処

ガウス分布のような単純な潜在表現に制限されている点

- 混合ガウス分布による対処

=> 提案モデルでは幾何学的なアプローチをとるから上記のような確率的アプローチとは異なる

Decodingとランキング

A diversity-promoting objective function for neural conversation models(NAACL2016) の話です。

マルチタスク学習

機械翻訳に置いてモノリンガルデータの活用でマルチタスク学習がうまくいき、対話にも似たアイディアが提案されており、

- Seq2Seqで対話対の学習

- AutoEncoderで特有の話者の対話文ではないデータからの学習

上記2つのモデルでdecoderは共有し、交互に学習する

SPACE FUSION MODELとは?

モデルアーキテクチャ

図が全てです。

- src-tarの間のmappingを学習するSeq2Seq

- tarについて学習するAutoEncoder

- 両者の潜在変数の内挿に当たる潜在変数の導入

といったことをしており、最後の項目が提案モデルの新規性の1つだと言えます。 Seq2SeqとAutoEncoderのlossに、この新しく導入した潜在変数にまつわるLoss(2項分)を正則化項として追加して学習を行います

- interpolation loss

この項の役割は「同じ方向に並ぶ点(潜在変数)から異なる応答が生成されることを防ぐ」ことです。

(uは[0,1]の一様分布から)と表現され、まさしく内挿を表現しています。

- fusion loss

この項の役割は「各対話対におけるSeq2SeqとAutoEncoderの潜在変数をなるべく近づけ、かつ全体的に潜在変数が散らばる」ことです。

上記2つのlossを合わせたモデル全体のlossは以下のようになっており、と

は各lossの重みに相当します。

実験

データ

上図がデータに関する情報です。*2

モデルパラメータ

| Category | Item | Value |

|---|---|---|

| Encoder(GRU*2) | dimention | 128 |

| Decoder(GRU*2) | dimention | 128 |

| Noise Layer | σ | 0.1 |

| Loss Weight | α | 1 |

| β | 30 | |

| Optimizer | method | Adam |

| learning rate | 0.001 |

評価指標

- 自動評価: BLEU(4-gram)のF1

- 人手評価: 関連性・面白さの2項目について3人の評価者に1~5のリッカート尺度

ベースライン

- Seq2Seq+Sampling

vanilla seq2seqの利用

- CVAE+BOW

Learning discourse-level diversity for neural dialog models using conditional variational autoencoders (ACL2017)

- MTask

Multi-task learning for speaker-role adaptation in neural conversation models(IJCNLP2017)

結果と分析

潜在空間に対する考察

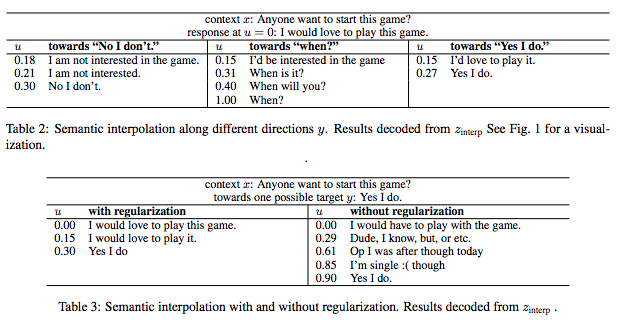

- 関連性と多様性がちゃんとdisentangleされたような空間になっているか?

- 意味が滑らかに変化する際に穴があるような空間になっていないか?(よくわからない表現になってしまったorz

3つの方向(今回はNo I don't などの各発話が方向に相当)と距離(今回はパラメータuにより操作されている)に関しての事例が上図。 概ね、各方向ごとの多様性、距離ごとの関連性の変化が意図通りに見て取れている。

方向と多様性

正則化項のある、なしでどう変わるかを見るために、1つのcontext()に対して複数の参照があるresponse(

)について、

異なるresponse間の潜在変数でのcos類似度を見た結果、正則化を入れない場合はほぼ類似しているが、入れると類似してないことが見て取れる

=>正則化により方向が異なるように学習されていると言える!

距離と関連性

(Perplexityをみていたけど、なんで良いと言えるかはよくわからなかった・・・orz)

自動評価

評価項目は前章参照

ベースラインより良い(それはそう)

人手評価

評価項目は前章参照

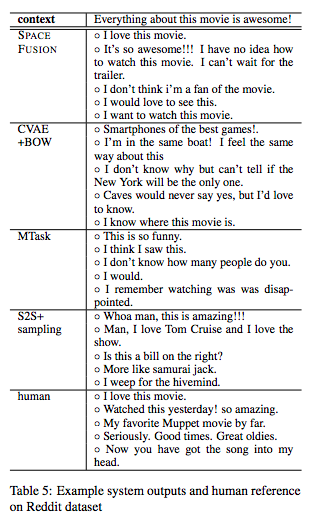

提案モデルが、最も良いが人手とはまだ1pt程度の開きがある。 Seq2Seq+Samplingもそこそこいい感じの結果に見える。

ちなみに、各手法の生成結果例は以下

(this movieという文脈が挟まるような例を出すのはどうなんだろうかと思わなくもない)

所感

最初の図のような感じで応答の多様性と関連性が理解できるのは良いなと思いつつ、 距離に関しての変数uがどれくらいピーキに効いてくるのかをPerplexiy以外の尺度で見られると嬉しいかな。

(方向ごとにuの効き具合がどう異なるのかを定性的に見たいくらいの意味合い)

また、多様性毎(?)に方向が散らばってくれるのはわかったが、 どの程度の方向の幅ごとに大まかな意味合いの異なるものが存在するのかとかも気になった。

*1:https://www.aclweb.org/anthology/N19-1125

*2:実験では、1つのcontextに対して複数のresponseがあるような対話データを用いていますが、これが完全な1対1のデータを用いた場合になるのか気になります。